모델 컨텍스트 프로토콜(MCP): 단 한 번의 프롬프트로 완성하는 고품질 AI 응답 기술

해당 블로그 글은 Anthropic 웹사이트의 공식 문서를 참고하여 작성되었습니다.

모델 컨텍스트 프로토콜(MCP): AI와 데이터를 연결하는 혁신적인 표준 가이드

목차

MCP란 무엇인가?

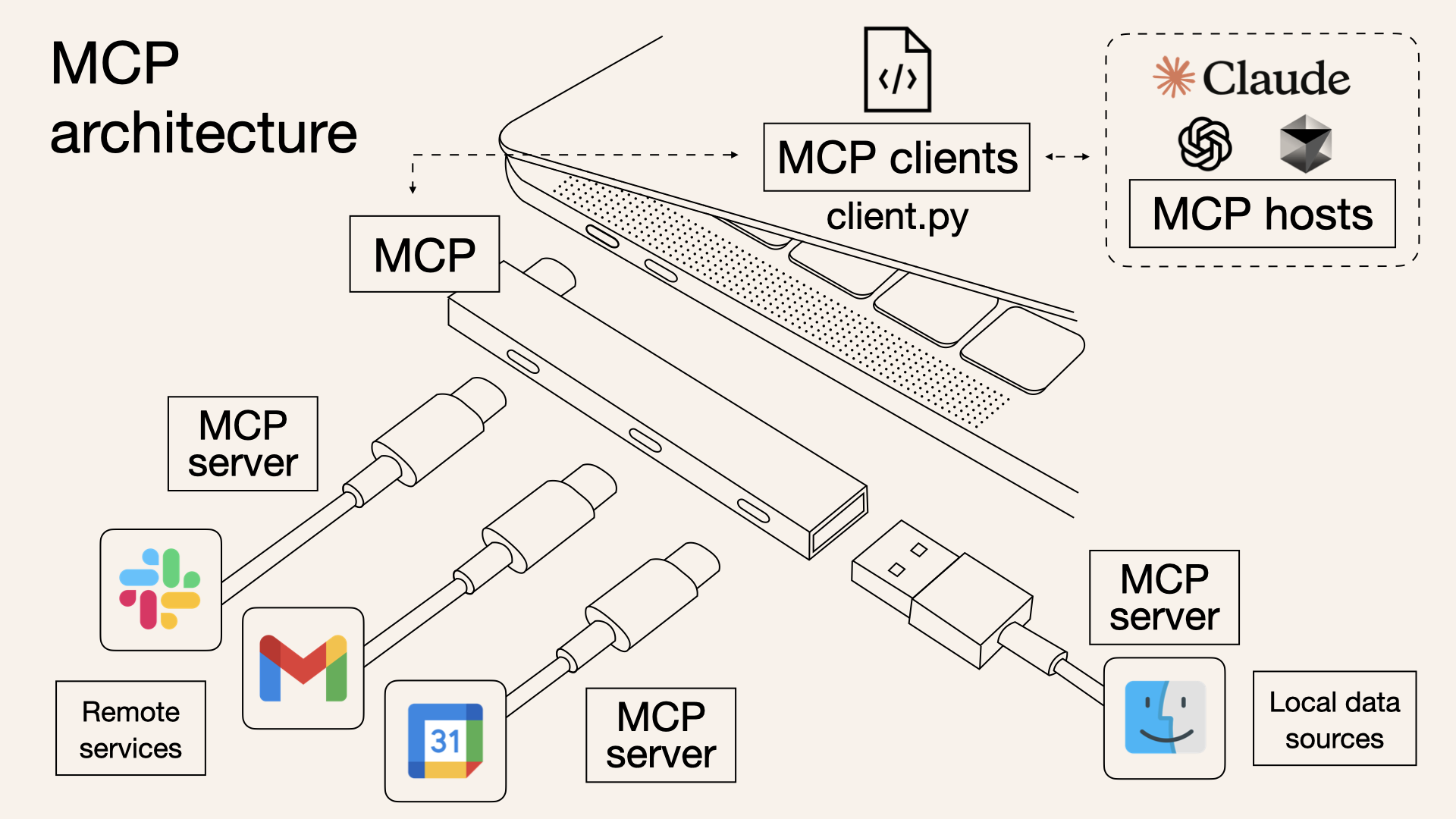

모델 컨텍스트 프로토콜(Model Context Protocol, MCP)은 대규모 언어 모델(LLM)이 외부 데이터 소스와 통신하는 방식을 표준화하는 혁신적인 프로토콜입니다.

쉽게 비유하자면, MCP는 AI 세계의 HTTP 프로토콜 또는 USB-C 포트와 같습니다. 웹 브라우저와 서버가 HTTP를 통해 소통하듯, AI 모델과 다양한 데이터 소스가 MCP를 통해 원활하게 연결됩니다. 이를 통해 개발자는 ChatGPT, Claude, Gemini와 같은 AI 모델이 내부 데이터베이스, API, 파일 시스템 등 다양한 정보 소스에 접근할 수 있게 할 수 있습니다.

“MCP는 AI에게 USB-C와 같은 표준 인터페이스를 제공합니다. 하나의 통일된 방식으로 모든 데이터 소스에 연결됩니다.” - Anthropic 연구팀

2023년 Anthropic에서 처음 공개한 이 프로토콜은 이제 AI 기술의 핵심 연결 표준으로 자리잡고 있습니다.

왜 MCP가 필요한가?

대규모 언어 모델(LLM)은 놀라운 능력을 보여주고 있지만, 몇 가지 핵심적인 한계를 가지고 있습니다:

1. 지식의 한계와 업데이트 문제

LLM은 훈련된 데이터까지만 알고 있으며, 그 이후의 정보는 접근할 수 없습니다. 예를 들어, GPT-4는 2023년 4월까지의 정보만 알고 있으며, 새로운 모델을 훈련하는 데는 엄청난 자원과 시간이 필요합니다. 이는 AI 모델의 지식이 항상 ‘구식’이 될 수밖에 없는 문제를 만듭니다.

2. 기업 특화 데이터에 대한 접근 부족

공개 데이터로 훈련된 LLM은 기업의 내부 문서, 제품 정보, 비즈니스 프로세스와 같은 특정 도메인 지식에 접근할 수 없습니다. 이는 기업 환경에서 AI의 실용성을 크게 제한합니다.

3. 데이터 소스 통합의 표준화 부재

지금까지 LLM에 외부 데이터를 제공하는 방법은 RAG(검색 증강 생성), 로컬 지식 기반, 플러그인 등 다양했지만 표준화된 방식이 없었습니다. 이로 인해 시스템 간 통합이 복잡하고 비용이 많이 들었습니다.

MCP는 이러한 문제들을 해결하기 위해 등장했습니다. MCP를 통해 AI 모델은 실시간 데이터에 접근하고, 기업 특화 정보를 활용하며, 표준화된 방식으로 다양한 시스템과 통합할 수 있게 됩니다.

MCP의 작동 원리

MCP는 클라이언트-서버 아키텍처를 기반으로 작동합니다. 전체 시스템은 세 가지 핵심 구성 요소로 이루어져 있습니다:

1. MCP 서버

MCP 서버는 AI 모델이 사용할 수 있는 도구와 데이터 액세스 기능을 제공하는 프로그램입니다. 이는 로컬에서 실행되거나 원격 서버에 배포될 수 있습니다. 각 MCP 서버는 다음과 같은 기능을 제공합니다:

- 리소스(Resources): 파일이나 API 응답과 같은 데이터

- 도구(Tools): AI가 호출할 수 있는 함수

- 프롬프트(Prompts): 특정 작업을 위한 템플릿

2. MCP 클라이언트

MCP 클라이언트는 AI 모델과 MCP 서버를 연결하는 브리지 역할을 합니다. LLM에 내장되어 다음과 같은 작업을 수행합니다:

- LLM으로부터 요청 수신

- 적절한 MCP 서버로 요청 전달

- 결과를 LLM에 반환

3. MCP 호스트

MCP 호스트는 Claude Desktop, IDE(Cursor 등), 또는 MCP를 활용하는 AI 애플리케이션과 같은 프로그램입니다. 이러한 애플리케이션은 사용자와 AI 모델 간의 인터페이스를 제공하면서, MCP 클라이언트를 통합하여 확장된 기능을 활용합니다.

💡 쉽게 이해하기: MCP 서버는 도서관 사서, MCP 클라이언트는 책을 요청하는 사람, 그리고 MCP 호스트는 도서관 건물과 같습니다. 사용자(질문하는 사람)가 도서관(호스트)에 가서 책을 요청하면, 사서(서버)가 책(데이터)을 찾아 제공합니다.

MCP의 주요 이점

MCP를 사용하면 다음과 같은 다양한 이점을 얻을 수 있습니다:

1. 풍부한 사전 구축 통합

MCP는 파일 시스템, 데이터베이스(PostgreSQL, SQLite), 개발 도구(Git, GitHub), 네트워크 도구, 생산성 도구(Slack, Google Drive) 등 다양한 서비스와의 통합을 제공합니다. 개발자는 이러한 통합을 처음부터 구축할 필요 없이, 사전 제작된 커넥터를 사용할 수 있습니다.

2. LLM 제공자 간의 유연한 전환

MCP를 사용하면 GPT-4, Claude, Gemini 등 다양한 AI 모델을 쉽게 전환할 수 있습니다. 전체 애플리케이션의 통합 로직을 다시 작성할 필요 없이 모델만 변경하면, 모든 데이터 및 도구 통합은 그대로 유지됩니다.

3. 복잡한 AI 워크플로우 구축

MCP를 통해 여러 데이터베이스를 쿼리하고, 특정 도구를 사용하며, 보고서를 생성하는 등 복잡한 워크플로우를 구축할 수 있습니다. 이는 AI 모델이 더 다양하고 복잡한 작업을 수행할 수 있게 해줍니다.

4. 보안과 개인정보 보호

MCP는 로컬 처리, 명시적 권한 부여, 안전한 액세스 토큰 등을 통해 보안과 개인정보 보호를 우선시합니다. 민감한 데이터가 필요 이상으로 외부로 노출되지 않도록 설계되었습니다.

MCP 구현 가이드

실제로 MCP 서버를 구현하는 방법을 간단한 날씨 정보 서버 예제를 통해 알아보겠습니다:

1단계: 환경 설정

1

2

3

4

5

6

7

8

9

10

11

# uv 설치 (패키지 관리 도구)

curl -LsSf https://astral.sh/uv/install.sh | sh

# 프로젝트 설정

uv init weather-server

cd weather-server

uv venv

source .venv/bin/activate # MacOS/Linux

# 필요한 패키지 설치

uv add "mcp[cli]" httpx

2단계: 서버 구현

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

144

145

146

147

148

149

150

151

152

153

import asyncio

import sys

from typing import Optional

from contextlib import AsyncExitStack

from mcp import ClientSession, StdioServerParameters

from mcp.client.stdio import stdio_client

from anthropic import Anthropic

from dotenv import load_dotenv

load_dotenv() # .env에서 환경 변수 로드

class MCPClient:

def __init__(self):

# 세션 및 클라이언트 객체 초기화

self.session: Optional[ClientSession] = None

self.exit_stack = AsyncExitStack()

self.anthropic = Anthropic()

async def connect_to_server(self, server_script_path: str):

"""MCP 서버에 연결합니다.

Args:

server_script_path: 서버 스크립트 경로(.py 또는 .js)

"""

is_python = server_script_path.endswith('.py')

is_js = server_script_path.endswith('.js')

if not (is_python or is_js):

raise ValueError("서버 스크립트는 .py 또는 .js 파일이어야 합니다")

command = "python" if is_python else "node"

server_params = StdioServerParameters(

command=command,

args=[server_script_path],

env=None

)

stdio_transport = await self.exit_stack.enter_async_context(stdio_client(server_params))

self.stdio, self.write = stdio_transport

self.session = await self.exit_stack.enter_async_context(ClientSession(self.stdio, self.write))

await self.session.initialize()

# 사용 가능한 도구 나열

response = await self.session.list_tools()

tools = response.tools

print("\n서버에 연결되었습니다. 사용 가능한 도구:", [tool.name for tool in tools])

async def process_query(self, query: str) -> str:

"""Claude와 사용 가능한 도구를 사용하여 쿼리를 처리합니다."""

messages = [

{

"role": "user",

"content": query

}

]

response = await self.session.list_tools()

available_tools = [{

"name": tool.name,

"description": tool.description,

"input_schema": tool.inputSchema

} for tool in response.tools]

# 초기 Claude API 호출

response = self.anthropic.messages.create(

model="claude-3-5-sonnet-20241022",

max_tokens=1000,

messages=messages,

tools=available_tools

)

# 응답 처리 및 도구 호출 처리

final_text = []

assistant_message_content = []

for content in response.content:

if content.type == 'text':

final_text.append(content.text)

assistant_message_content.append(content)

elif content.type == 'tool_use':

tool_name = content.name

tool_args = content.input

# 도구 호출 실행

result = await self.session.call_tool(tool_name, tool_args)

final_text.append(f"[도구 호출 중: {tool_name}, 인수: {tool_args}]")

assistant_message_content.append(content)

messages.append({

"role": "assistant",

"content": assistant_message_content

})

messages.append({

"role": "user",

"content": [

{

"type": "tool_result",

"tool_use_id": content.id,

"content": result.content

}

]

})

# Claude에서 다음 응답 가져오기

response = self.anthropic.messages.create(

model="claude-3-5-sonnet-20241022",

max_tokens=1000,

messages=messages,

tools=available_tools

)

final_text.append(response.content[0].text)

return "\n".join(final_text)

async def chat_loop(self):

"""인터랙티브 채팅 루프를 실행합니다."""

print("\nMCP 클라이언트가 시작되었습니다!")

print("쿼리를 입력하거나 'quit'를 입력하여 종료하세요.")

while True:

try:

query = input("\n쿼리: ").strip()

if query.lower() == 'quit':

break

response = await self.process_query(query)

print("\n" + response)

except Exception as e:

print(f"\n오류: {str(e)}")

async def cleanup(self):

"""리소스를 정리합니다."""

await self.exit_stack.aclose()

async def main():

if len(sys.argv) < 2:

print("사용법: python client.py <path_to_server_script>")

sys.exit(1)

client = MCPClient()

try:

await client.connect_to_server(sys.argv[1])

await client.chat_loop()

finally:

await client.cleanup()

if __name__ == "__main__":

asyncio.run(main())

3단계: Claude for Desktop과 연결

Claude for Desktop의 구성 파일을 설정하여 서버를 연결합니다:

1

2

3

4

5

6

7

8

9

10

11

12

13

{

"mcpServers": {

"weather": {

"command": "uv",

"args": [

"--directory",

"/절대/경로/weather-server",

"run",

"server.py"

]

}

}

}

이제 Claude for Desktop에서 “서울의 현재 날씨는 어때?”와 같은 질문을 할 수 있고, AI는 실시간 날씨 데이터를 가져와 응답할 수 있습니다.

4단계: MCP 클라이언트 구현

MCP 서버와 통신할 수 있는 커스텀 클라이언트를 개발하는 방법도 있습니다:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

144

145

146

147

148

149

150

151

152

153

import asyncio

import sys

from typing import Optional

from contextlib import AsyncExitStack

from mcp import ClientSession, StdioServerParameters

from mcp.client.stdio import stdio_client

from anthropic import Anthropic

from dotenv import load_dotenv

load_dotenv() # .env에서 환경 변수 로드

class MCPClient:

def __init__(self):

# 세션 및 클라이언트 객체 초기화

self.session: Optional[ClientSession] = None

self.exit_stack = AsyncExitStack()

self.anthropic = Anthropic()

async def connect_to_server(self, server_script_path: str):

"""MCP 서버에 연결합니다.

Args:

server_script_path: 서버 스크립트 경로(.py 또는 .js)

"""

is_python = server_script_path.endswith('.py')

is_js = server_script_path.endswith('.js')

if not (is_python or is_js):

raise ValueError("서버 스크립트는 .py 또는 .js 파일이어야 합니다")

command = "python" if is_python else "node"

server_params = StdioServerParameters(

command=command,

args=[server_script_path],

env=None

)

stdio_transport = await self.exit_stack.enter_async_context(stdio_client(server_params))

self.stdio, self.write = stdio_transport

self.session = await self.exit_stack.enter_async_context(ClientSession(self.stdio, self.write))

await self.session.initialize()

# 사용 가능한 도구 나열

response = await self.session.list_tools()

tools = response.tools

print("\n서버에 연결되었습니다. 사용 가능한 도구:", [tool.name for tool in tools])

async def process_query(self, query: str) -> str:

"""Claude와 사용 가능한 도구를 사용하여 쿼리를 처리합니다."""

messages = [

{

"role": "user",

"content": query

}

]

response = await self.session.list_tools()

available_tools = [{

"name": tool.name,

"description": tool.description,

"input_schema": tool.inputSchema

} for tool in response.tools]

# 초기 Claude API 호출

response = self.anthropic.messages.create(

model="claude-3-5-sonnet-20241022",

max_tokens=1000,

messages=messages,

tools=available_tools

)

# 응답 처리 및 도구 호출 처리

final_text = []

assistant_message_content = []

for content in response.content:

if content.type == 'text':

final_text.append(content.text)

assistant_message_content.append(content)

elif content.type == 'tool_use':

tool_name = content.name

tool_args = content.input

# 도구 호출 실행

result = await self.session.call_tool(tool_name, tool_args)

final_text.append(f"[도구 호출 중: {tool_name}, 인수: {tool_args}]")

assistant_message_content.append(content)

messages.append({

"role": "assistant",

"content": assistant_message_content

})

messages.append({

"role": "user",

"content": [

{

"type": "tool_result",

"tool_use_id": content.id,

"content": result.content

}

]

})

# Claude에서 다음 응답 가져오기

response = self.anthropic.messages.create(

model="claude-3-5-sonnet-20241022",

max_tokens=1000,

messages=messages,

tools=available_tools

)

final_text.append(response.content[0].text)

return "\n".join(final_text)

async def chat_loop(self):

"""인터랙티브 채팅 루프를 실행합니다."""

print("\nMCP 클라이언트가 시작되었습니다!")

print("쿼리를 입력하거나 'quit'를 입력하여 종료하세요.")

while True:

try:

query = input("\n쿼리: ").strip()

if query.lower() == 'quit':

break

response = await self.process_query(query)

print("\n" + response)

except Exception as e:

print(f"\n오류: {str(e)}")

async def cleanup(self):

"""리소스를 정리합니다."""

await self.exit_stack.aclose()

async def main():

if len(sys.argv) < 2:

print("사용법: python client.py <path_to_server_script>")

sys.exit(1)

client = MCPClient()

try:

await client.connect_to_server(sys.argv[1])

await client.chat_loop()

finally:

await client.cleanup()

if __name__ == "__main__":

asyncio.run(main())

실제 활용 사례

MCP는 다양한 산업과 응용 분야에서 AI의 역량을 크게 확장시킵니다:

1. 콘텐츠 생성 및 마케팅

MCP 적용 전:

1

"우리 회사 제품에 대한 블로그 글을 작성해줘."

MCP 적용 후:

1

2

3

4

5

6

7

8

<역할>

당신은 B2B SaaS 마케팅 전문가입니다.

<배경>

회사 데이터베이스에서 가져온 제품 정보를 기반으로 글을 작성합니다.

<지시사항>

최신 CRM 제품의 주요 기능 5가지를 강조하는 블로그 글을 작성하세요.

MCP는 최신 제품 데이터베이스에 접근하여 정확한 제품 정보를 기반으로 콘텐츠를 생성할 수 있습니다. 이는 마케팅 팀이 항상 최신 정보로 콘텐츠를 생성할 수 있게 합니다.

2. 데이터 분석 및 비즈니스 인텔리전스

MCP를 통해 AI는 기업의 데이터 웨어하우스, BI 도구, 분석 플랫폼에 직접 접근할 수 있습니다. 경영진은 “지난 분기 대비 지역별 매출 변화를 분석해줘”와 같은 자연어 질문을 하면, AI가 실시간 데이터를 분석하여 인사이트를 제공할 수 있습니다.

3. 개발자 생산성 향상

MCP는 코드 저장소, 이슈 트래커, CI/CD 파이프라인과 같은 개발 도구와 AI를 연결할 수 있습니다. 개발자는 “이 버그의 원인을 찾아줘” 또는 “이 기능을 구현하는 코드를 작성해줘”와 같은 요청을 할 수 있으며, AI는 실제 코드베이스와 컨텍스트를 기반으로 응답합니다.

4. 고객 서비스 및 지원

MCP를 CRM 시스템, 지식 기반, 티켓팅 시스템과 연결하면, AI 지원 봇이 고객의 질문에 더 정확하고 맞춤화된 답변을 제공할 수 있습니다. 고객의 이전 상호작용 기록, 구매 내역, 제품 사용 패턴 등에 접근하여 맥락을 이해할 수 있습니다.

MCP의 미래 전망

MCP는 AI 기술 발전에 중요한 이정표가 될 것입니다. 앞으로 예상되는 발전 방향은 다음과 같습니다:

1. 표준화와 생태계 확장

더 많은 AI 기업과 도구 제공업체가 MCP를 지원하면서, 통합된 AI 생태계가 형성될 것입니다. 이는 “한 번 개발하고, 어디서나 실행” 접근 방식을 가능하게 합니다.

2. 엔터프라이즈 채택 증가

기업들은 MCP를 통해 내부 시스템과 AI를 안전하게 통합하는 방법을 발견하게 될 것입니다. 이는 AI의 기업 도입을 가속화할 것입니다.

3. 복잡한 AI 워크플로우

MCP는 여러 시스템과 도구를 연결하는 복잡한 AI 워크플로우를 가능하게 합니다. 예를 들어, 데이터 분석, 보고서 생성, 이메일 발송까지 하나의 프로세스로 자동화할 수 있습니다.

4. 개인화된 AI 경험

사용자 데이터와 선호도에 접근할 수 있는 MCP의 능력은 더욱 개인화된 AI 경험을 가능하게 할 것입니다.

자주 묻는 질문

MCP는 오픈 소스인가요?

예, MCP는 개방형 표준으로, 모든 개발자가 자유롭게 사용하고 기여할 수 있습니다.

MCP를 사용하기 위해 특별한 AI 모델이 필요한가요?

아니요, MCP는 다양한 AI 모델(Claude, GPT, Gemini 등)과 함께 사용할 수 있습니다. 현재는 주로 Claude for Desktop이 기본 지원을 제공하지만, 다른 모델과도 통합할 수 있습니다.

MCP 서버는 어디에서 실행되나요?

MCP 서버는 로컬 컴퓨터에서 실행하거나 클라우드에 배포할 수 있습니다. 로컬에서 실행하면 민감한 데이터가 외부로 전송되지 않는 장점이 있습니다.

MCP는 보안이 안전한가요?

MCP는 설계 시 보안을 고려했습니다. 사용자는 AI 모델이 접근할 수 있는 도구와 데이터를 명시적으로 제어할 수 있으며, 민감한 데이터 처리를 위한 안전한 메커니즘을 제공합니다.

어떤 프로그래밍 언어로 MCP 서버를 개발할 수 있나요?

현재 MCP는 Python, JavaScript/TypeScript, Java, Kotlin 등 다양한 언어를 지원합니다.

결론

모델 컨텍스트 프로토콜(MCP)은 AI와 데이터 소스 간의 연결을 표준화함으로써 AI의 가능성을 새롭게 확장하고 있습니다. 지식의 한계, 도메인 특화 데이터 접근, 통합의 복잡성과 같은 기존 AI의 주요 과제를 해결함으로써, MCP는 AI가 더 정확하고, 맞춤화되고, 실용적인 응답을 제공할 수 있게 합니다.

개발자, 기업, 그리고 최종 사용자 모두에게 MCP는 강력한 도구입니다. 개발자는 표준화된 방식으로 AI 통합을 구축할 수 있고, 기업은 내부 시스템과 AI를 안전하게 연결할 수 있으며, 사용자는 더 정확하고 맞춤화된 AI 경험을 얻을 수 있습니다.

MCP의 등장으로 인해 AI는 이제 단순한 텍스트 생성 도구를 넘어, 실제 세계의 데이터와 시스템과 상호작용하는 진정한 지능형 어시스턴트로 발전하고 있습니다. AI의 미래는 더 이상 고립된 모델이 아니라, 연결된 생태계 속에서 진화하고 있습니다.

“MCP는 AI 모델이 단순한 ‘제한된 지식의 섬’에서 벗어나, 광범위한 정보와 도구의 ‘대륙’으로 확장할 수 있게 하는 다리입니다.” - AI 연구자